Notice

Recent Posts

Recent Comments

Link

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | ||||||

| 2 | 3 | 4 | 5 | 6 | 7 | 8 |

| 9 | 10 | 11 | 12 | 13 | 14 | 15 |

| 16 | 17 | 18 | 19 | 20 | 21 | 22 |

| 23 | 24 | 25 | 26 | 27 | 28 | 29 |

| 30 |

Tags

- list

- Jacobian Matrix

- 유니티

- 리스트

- 데이터 분석

- ML-Agent

- reinforcement learning

- Laplacian

- Series

- David Silver

- 모두를 위한 RL

- 사이킷런

- Deep Learning

- Linear algebra

- convex optimization

- optimization

- machine learning

- statistics

- pandas

- 김성훈 교수님

- paper

- 논문

- Hessian Matrix

- unity

- neural network

- rl

- 강화학습

- 딥러닝

- Python Programming

- 판다스

Archives

RL Researcher

Ensemble Learning 본문

1. Ensemble Learning이란

- Ensemble : '조화'라는 사전적 의미를 지님

- Ensemble Learning

- 여러개의 기본 모델을 활용하여 하나의 새로운 모델을 만들어 내는 개념입니다.

- 이때의 기본 모델(base model)을 weak learner, classifier, base learner, single learner라고 부릅니다.

- 다양한 learner를 만들면 전체의 모델의 성능이 증가할 수 있습니다.

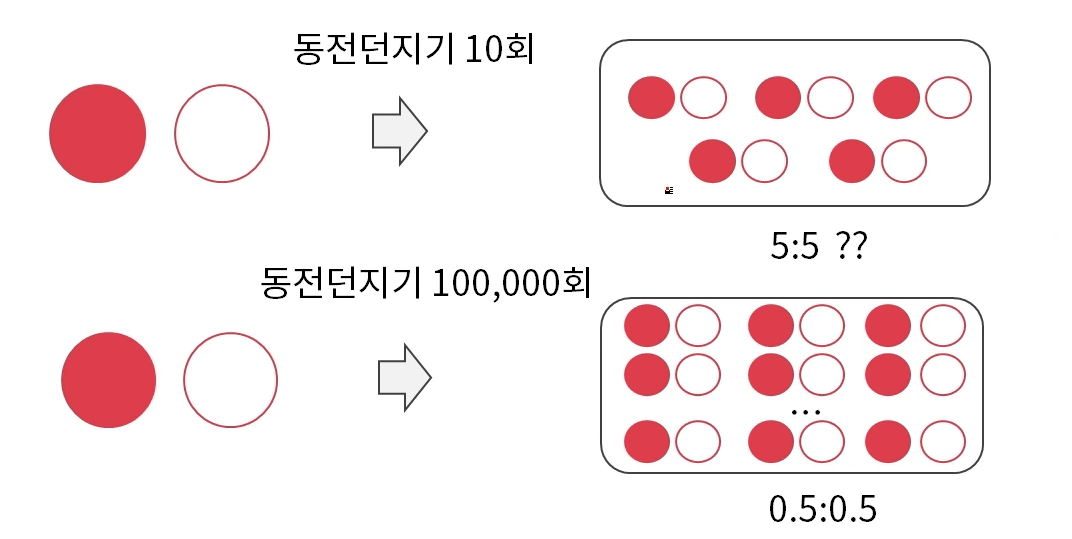

2. 대수의 법칙

- 대수의 법칙(law of large numbers)

- 큰 모집단(population)에서 무작위로 뽑은 표본의 평균이 전체 모집단의 평균과 가까울 가능성이 높다는 통계와 확률 분야의 기본 개념입니다.

많은 시행(다수의 사람)의 결과가 수학적(이성적)으로 합리적인 결과를 가져옵니다.

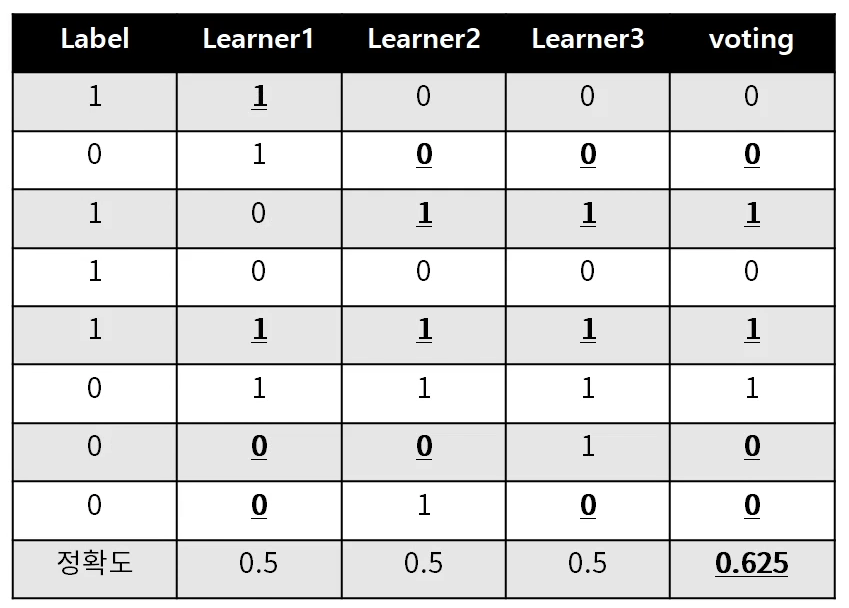

3.Ensemble Learning

- L classifier with p proabbility of wrong,(L개의 clssifier, 틀릴 확률이 p)

p < 1/2 -> L이 증가함에 따라 기댓값은 낮아짐

p > 1/2 -> L이 증가함에 따라 기댓값이 올라감

- 이진 분류 문제에서 각각의 base learner들은 0.5 이상의 정확도를 가져야 합니다.

- 각각의 분류기는 독립이여야합니다.

위의 예제를 보시면 Ensemble Learning을 알 수 있습니다.

4. Ensemble Learning의 종류

- Bagging : 모델을 다양하게 만들기 위해 데이터를 재구성 하는 것입니다.

- RandomForest : 모델을 다양하게 만들기 위해 데이터 뿐만 아니라, 변수도 재구성하는 것입니다.

- Boosting : 맞추기 어려운 데이터에 대해 좀더 가중치를 두어 학습하는 개념

- Adaboost, Gradient boosting(Xgboost, LightGBM, Catboost)

위의 3가지는 Tree기반의 단일 모델입니다.(패키지 함수)

- Stacking : 모델의 output값을 새로운 독립변수로 사용하는 것입니다.(Ensemble 한 개념)

'Machine-Learning' 카테고리의 다른 글

| Machine Learning의 종류 (0) | 2020.12.31 |

|---|---|

| 지도학습(Supervised), 비지도학습(Unsupervised), 강화학습(Reinforcement) (0) | 2020.12.30 |

| Machine Learning 개념 (0) | 2020.12.30 |

Comments