Notice

Recent Posts

Recent Comments

Link

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | |||

| 5 | 6 | 7 | 8 | 9 | 10 | 11 |

| 12 | 13 | 14 | 15 | 16 | 17 | 18 |

| 19 | 20 | 21 | 22 | 23 | 24 | 25 |

| 26 | 27 | 28 | 29 | 30 | 31 |

Tags

- neural network

- optimization

- pandas

- Laplacian

- 판다스

- 유니티

- David Silver

- reinforcement learning

- 논문

- 김성훈 교수님

- Python Programming

- Deep Learning

- 모두를 위한 RL

- 강화학습

- ML-Agent

- 딥러닝

- Linear algebra

- unity

- statistics

- 리스트

- convex optimization

- list

- Series

- machine learning

- paper

- Hessian Matrix

- rl

- Jacobian Matrix

- 사이킷런

- 데이터 분석

Archives

RL Researcher

지도학습(Supervised), 비지도학습(Unsupervised), 강화학습(Reinforcement) 본문

Machine-Learning

지도학습(Supervised), 비지도학습(Unsupervised), 강화학습(Reinforcement)

Lass_os 2020. 12. 30. 23:501. 지도 학습(Supervised Learning)

Y = f (X)에 대하여 입력변수(X)와 출력변수(Y)의 관계에 대하여 모델링 하는것 (Y에 대하여 예측 또는 분류하는 문제)

- 회귀(Regression) : 입력 변수 X에 대해서 연속형 출력 변수 Y를 예측

- 분류(Classification) : 입력 변수 X에 대해서 이산형 출력 변수 Y(class)를 예측

2. 비지도 학습(Unsupervised Learning)

출력 변수(Y)가 존재하지 않고, 입력 변수(X)간의 관계에 대해 모델링 하는 것

- 군집 분석 : 유사한 데이터끼리 그룹화하는 것

- PCA : 독립변수들의 차원을 축소화하는 것

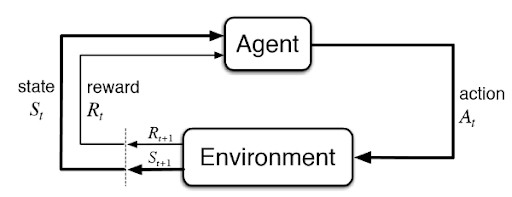

3. 강화학습(Reinforcement Learning)

- 수 많은 시뮬레이션을 통해 현재의 선택이 먼 미래에 보상이 최대가 되도록 학습하는 것

- Agent가 Environment에서 action을 취하고 보상을 받고 이 보상이 최대가 되도록 최적의 action을 취하는 방법을 배움

4. 정리

지도학습(Supervised Learning)

- Input, output 데이터가 존재함.

- 정답이 있음(Labeled data)

비지도학습(Unsupervised Learning)

- Input 데이터만 존재함.

- 정답이 존재하지 않음(Unlabeled data)

강화학습(Reinforcement Learning)

- 데이터 셋이 존재하지 않음.

- 상황과 행동이 존재함시뮬레이션을 계속 합니다.

- 결정을 만들어냅니다.

'Machine-Learning' 카테고리의 다른 글

| Machine Learning의 종류 (0) | 2020.12.31 |

|---|---|

| Machine Learning 개념 (0) | 2020.12.30 |

| Ensemble Learning (0) | 2020.12.29 |

Comments